Menurut Hsiao (1992), keuntungan-keuntungan menggunakan analisis regresi data panel adalah:

- Memperoleh hasil estimasi yang lebih baik karena seiring dengan

peningkatan jumlah observasi yang otomatis berimplikasi pada peningkatan

derajat kebebasan (degree of freedom);

- Menghindari kesalahan penghilangan variable (omitted variable problem).

Menurut Baltagi (1995; hlm. 4-7), keuntungan-keuntungan menggunakan analisis regresi data panel antara lain:

- Mengatasi masalah heterogenitas individu (individual heterogeneity);

- Memberikan data yang lebih informatif, mengurangi masalah

kolinieritas pada variable, mengatasi masalah penghilangan variabel

(ommited variabel), dan menghasilkan degree of freedom yang lebih besar;

- Mempelajari perubahan yang bersifat dinamis (dynamics of adjustment);

- Dapat mengidentifikasi dan menghitung efek yang tidak dapat dilakukan pada analisis time series atau cross section murni;

- Dapat mengurangi bias dalam pengestimasian karena data cukup banyak.

Model regresi data panel yang umumnya digunakan terdapat tiga macam, yaitu:

- Commond Effects Model,

- Fixed Effects Model (Model Efek Tetap – MET), dan

- Random Effects Model (Model Efek Random – MER).

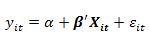

1. Commond Effects Model

Merupakan pendekatan model data panel yang paling sederhana karena hanya dengan mengkombinasikan data time series dan cross section dalam bentuk pool, dan menggunakan teknik kuadrat terkecil atau least square

untuk mengestimasi koefisiennya. Pada model ini tidak diperhatikan

dimensi waktu maupun individu, sehingga diasumsikan bahwa prilaku

individu tidak berbeda dalam berbagai kurun waktu.

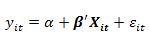

Persamaan regresinya dapat dituliskan sebagai berikut:

untuk i = 1, 2, …, N dan t = 1, 2, …,T, dimana N adalah jumlah unit/individu

cross section dan T adalah jumlah periode waktunya. Dari

commond effects model ini akan dapat dihasilkan N+T persamaan, yaitu sebanyak T persamaan

cross section dan sebanyak N persamaan

time series.

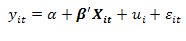

2. Fixed Effects Model

Asumsi pembuatan model yang menghasilkan intersep konstan untuk

setiap individu (i) dan waktu (t) dianggap kurang realistik sehingga

dibutuhkan model yang lebih dapat menangkap perbedaan tersebut. Model

efek tetap (fixed effects), model ini mengasumsikan bahwa perbedaan antar individu dapat diakomodasi dari perbedaan intersepnya. Untuk mengestimasi model Fixed Effects

dengan intersep berbeda antar individu, maka digunakan teknik variable

dummy. Model estimasi ini sering juga disebut dengan teknik Least Squares Dummy Variable (LSDV).

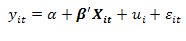

Persamaan regresinya adalah sebagai berikut:

untuk i = 1,2, …, N dan t = 1,2, …, T, dimana N adalah jumlah unit/individu

cross section dan T adalah jumlah periode waktunya.

3. Random Effects Model

Di dalam mengestimasi data panel dengan model Fixed Effects melalui teknik LSDV menunjukkan

ketidakpastian model yang digunakan. Untuk mengatasi masalah ini kita bisa menggunakan variabel residual yang dikenal sebagai model Random Effects.

Pada model ini, akan dipilih estimasi data panel dimana residual

mungkin saling berhubungan antar waktu dan antar individu. Oleh karena

itu, pada model ini diasumsikan bahwa ada perbedaan intersep untuk

setiap individu dan intersep tersebut merupakan variabel random atau

stokastik. Sehingga dalam model ini terdapat dua komponen residual,

yaitu residual secara menyeluruh, yang merupakan kombinasi time series dan cross section, dan residual secara individu yang merupakan karakteristik random dari observasi unit ke-i dan tetap sepanjang waktu.

Adapun persamaan regrsinya adalah sebagai berikut:

Ada beberapa asumsi yang harus dipenuhi dalam model efek random. Secara matematis, asumsi tersebut terdiri dari:

Hal ini berarti bahwa komponen error tidak berkorelasi satu sama lain dan tidak ada autokorelasi antara cross section dan time series. metode OLS tidak bisa digunakan untuk mendapatkan estimator yang efisien. Metode yang tepat untuk mengestimasi model random effects adalah Generalized Least Squares (GLS) dengan asumsi homoskedastik dan tidak ada cross sectional correlation. GLS merupakan OLS dengan transformasi variabel yang memenuhi asumsi standar dari OLS.

Pemilihan Model Regresi Data Panel

Dari ketiga model yang telah dijelaskan sebelumnya, maka selanjutnya

akan ditentukan model yang paling tepat untuk mengestimasi parameter

regresi data panel. Secara informal, ada beberapa pertimbangan untuk

menentukan model estimasi terbaik dari ketiga model estimasi data panel

sebagaimana telah dijelaskan di atas. Nachrowi dan Usman (2006)

menyatakan bahwa jika data panel yang dimiliki mempunyai waktu (T) lebih

besar dibandingkan dengan jumlah individu (N) maka disarankan untuk

menggunakan model fixed effects, sedangkan apabila jumlah data

panel yang dimiliki mempunyai jumlah waktu (T) lebih kecil disbanding

jumlah individu (N) maka disarankan menggunakan model random effects.

Secara formal terdapat tiga pengujian yang digunakan untuk memilih model regresi data panel terbaik antara model commond effects, model fixed effects, atau model random effectss, yaitu uji F yang digunakan untuk memilih antara model commond effectss atau model fixed effects; uji Lagrange Multiplier (LM) untuk memilih antara model commond effects atau model random effects; dan uji Hausman untuk memilih antara model fixed effects atau model random effects. Adapun penjelasan mengenai ketiga pengujian tersebut di atas adalah sebagai berikut:

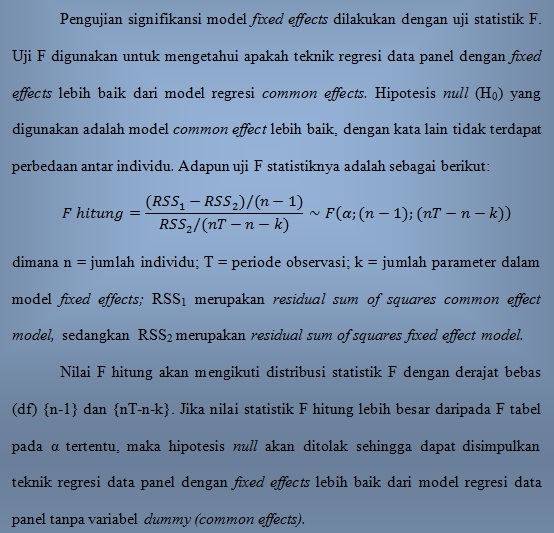

Pengujian Signifikansi Model Fixed Effects

Signifikansi model fixed effects dapat dilakukan dengan uji statistik F. Uji F digunakan untuk mengetahui apakah teknik regresi data panel dengan fixed effects lebih baik dari model regresi data panel tanpa variabel dummy (common effects) dengan melihat residual sum of squares (RSS). Hipotesis nol (H0) yang digunakan adalah bahwa intersep dan slope adalah sama.

Adapun uji F statistiknya adalah sebagai berikut:

dengan n = jumlah individu; T = jumlah periode waktu; K = banyaknya parameter dalam model

fixed effects; dan masing-masing merupakan

residual sum of squares teknik tanpa variabel

dummy dan teknik

fixed effects dengan variabel

dummy. Nilai statistik F akan mengikuti distribusi statistik F dengan derajat bebas (

dof)

sebesar/sebanyak n-1 untuk numerator dan sebesar nT-k untuk

denumerator. Jika nilai statistik F lebih besar dari nilai F table pada

tingkat signifikansi tertentu, maka hipotesis nol akan ditolak, yang

berarti asumsi koefisien intersep dan

slope adalah sama tidak berlaku, sehingga teknik regresi data panel dengan

fixed effects lebih baik dari model regresi data panel tanpa variabel

dummy atau

common effects.

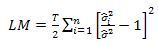

Pengujian Signifikansi Model Random Effects

Untuk mengetahui apakah model Random Effects lebih baik daripada model common effects maka dapat menggunakan uji Lagrange Multiplier (LM) yang dikembangkan oleh Bruesch-Pagan. Pengujian ini didasarkan pada nilai residual dari model common effects.Hipoesis

yang diajukan adalah intersep bukan merupakan variabel random atau

stokastik. Dengan kata lain varian dari residual pada persamaan (3-3)

bernilai nol.

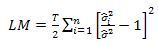

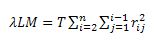

Adapun nilai statistik

LM dihitung berdasarkan formula sebagai berikut:

di mana n = jumlah individu; T = jumlah periode waktu dan adalah residual metode

common effects (OLS). Uji LM ini didasarkan pada distribusi

chi-square dengan derajat bebas sebesar 1. Jika hasil statistik LM lebih besar dari nilai kritis statistik

chi-square, maka hipotesis nol akan ditolak, yang berarti estimasi yang tepat untuk regresi data panel adalah metode

random effects daripada metode

common effects.

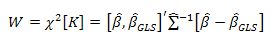

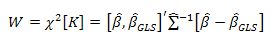

Pengujian Signifikansi Model Fixed Effects atau Model Random Effects

Untuk mengetahui apakah model fixed effect lebih baik dari model random effect, digunakan uji

Hausman. Dengan mengikuti kriteria Wald, nilai statistik Hausman ini akan mengikuti distribusi

chi-square sebagai berikut:

Statistik uji Hausman ini mengikuti disribusi statistik

chi-square dengan

derajat bebas sebanyak jumlah variabel independen (p). Hipotesis nol

ditolak jika nilai statistik Hausman lebih besar daripada nilai kritis

statistik

chi-square . Hal ini berarti bahwa model yang tepat untuk regresi data panel adalah model

Fixed Effects daripada model

Random Effects.

Pemilihan Model Estimator Terbaik dari Model Regresi Data Panel Terpilih

Untuk mendapatkan estimator terbaik dari model regresi data panel

terpilih, dilakukan pengujian terhadap struktur kovarians dari residual

model terpilih. Terdapat beberapa metode yang sesuai dengan asumsi pada

stuktur varians-covarians tersebut, yaitu struktur homoskedastik, asumsi

struktur heteroskedastik dan tidak ada korelasi antar individu (cross sectional correlation), asumsi heteroskedastik dan ada cross sectional correlation (Seemingly Uncorrelated Regression/SUR), dan asumsi adanya autokorelasi antar waktu pada error term.

Pemilihan Estimator Asumsi Homoskedastis atau Heteroskedastis

Pada pengujian ini, hipotesis nol (H

0) yang digunakan

adalah bahwa struktur varians-covarians residual bersifat homoskedastik.

Sementara hipotesis alternatifnya adalah struktur varians-covarians

residual bersifat heteroskedastik. Secara matematis, statistik uji yang

digunakan dapat dirumuskan sebagai berikut:

di mana T adalah jumlah observasi, n adalah jumlah individu,

sigma kuadrat i adalah varians residual persamaan ke-

i pada kondisi homoskedastik, dan

sigma kuadrat adalah

sum square residual persamaan

systempada

kondisi homoskedasik.Statistik uji LM ini mengikuti distribusi

statistik chi-square dengan derajat bebas sebanyak n-1. Jika nilai

statistik LM lebih besar dari nilai kritis statistik chi-square, maka

hipotesis nol akan ditolak, yang berarti struktur varians-covarians

residual bersifat homoskedastik. Prosedur yang digunakan dalam

pengolahan dengan

Eviews adalah

no-weight.

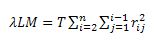

Pemilihan Estimator Asumsi Heteroskedastis Tanpa Korelasi Antar Individu atau Heteroskedastis Ada Korelasi Antar Individu.

Pengujian ini dilakukan apabila hasil pengujian LM pada poin (a)

menunjukkan bahwa struktur varians-covarians residual bersifat

heteroskedastik. Pada pengujian ini, hipotesis nol (H0) yang

digunakan adalah bahwa struktur varians-kovarians residual bersifat

heteroskedastik dan tidak ada korelasi antar individu (non cross sectional correlation). Sementara hipotesis alternatifnya (H1) adalah bahwa struktur varians-kovarians residual bersifat heteroskedastik dan ada ada korelasi antar individu (cross sectional correlation) atau Seemingly Uncorrelated Regression/SUR.

Secara sistematis, statistik uji yang digunakan dapat dirumuskan sebagai berikut:

dimana

r-square adalah

residual correlation coefficient. Statistik uji ini mengikuti distribusi statistik

chi-square dengan derajat bebas sebanyak n(n-1)/2. Jika nilai statistik observasi lebih besar dari nilai kritis statistik

chi-square,

maka hipotesis nol akan ditolak, yang berarti struktur varian-kovarians

residual bersifat heteroskedastik dan ada korelasi antar individu

(cross sectional correlation) atau

Seemingly Uncorrelated Regression/SUR. Dengan demikian prosedur yang digunakan dalam

Eviews adalah

cross-section SUR sedangkan jika hipotesis nol tidak ditolak, prosedur yang digunakan adalah

cross-section weights.

Untuk mengestimasi parameter dalam model dapat menggunakan bantuan software EViews 6.0

Semoga bermanfaat d(^.^)b

Sumber: